Każdej nocy nowoczesne teleskopy generują miliony alertów o potencjalnych zmianach na niebie. Większość z nich to zwykły „szum” – błędy instrumentów, smugi po satelitach czy promienie kosmiczne. Odfiltrowanie tego szumu, by znaleźć prawdziwe odkrycia, jak wybuchające gwiazdy, jest jednym z największych wyzwań współczesnej astronomii. Nowa generacja obserwatoriów, takich jak Vera C. Rubin Observatory, będzie produkować około 20 terabajtów danych każdej nocy, co uczyni manualną weryfikację całkowicie niemożliwą. Stworzenie inteligentnego i godnego zaufania partnera AI jest więc nie tyle innowacją, co koniecznością dla przyszłości odkryć kosmicznych.

Przełom w astronomii: AI uczy się kosmosu z 15 obrazków i wyjaśnia, co widzi

Sztuczna inteligencja od lat pomaga astronomom w analizie danych, ale często działa jak „czarna skrzynka” – dostarcza odpowiedź bez wyjaśnienia, jak do niej doszła. To zmusza naukowców do ślepego zaufania lub spędzania niezliczonych godzin na weryfikacji. Najnowsze badanie, przeprowadzone we współpracy między Uniwersytetem Oksfordzkim a Google Cloud, pokazuje, że ten model pracy odchodzi do przeszłości.

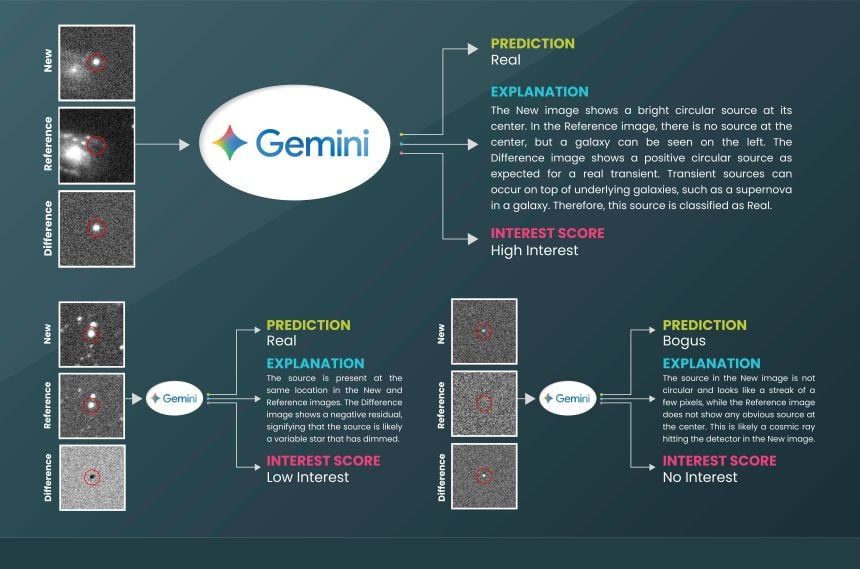

Analiza opublikowana w prestiżowym czasopiśmie Nature Astronomy dowodzi, że ogólnego przeznaczenia duży model językowy (w tym przypadku Google Gemini) można w prosty sposób przekształcić w eksperckiego asystenta astronoma. System ten nie tylko osiąga wysoką trafność w identyfikacji prawdziwych zjawisk kosmicznych, ale, co kluczowe, potrafi w przystępnym języku uzasadnić każdą swoją decyzję.

Nowy rodzaj partnera naukowego: przejrzystość zamiast „czarnej skrzynki”

Tradycyjne modele uczenia maszynowego używane w astronomii wymagały ogromnych, specjalistycznych zbiorów danych treningowych i głębokiej wiedzy z zakresu programowania AI. Działały one na zasadzie prostej klasyfikacji: „prawdziwy sygnał” lub „fałszywy sygnał”. Nowe podejście jest fundamentalnie inne.

Zespół badawczy zadał proste pytanie: czy model AI, który rozumie jednocześnie obrazy i tekst, może dorównać dokładnością specjalistycznym systemom, a jednocześnie wyjaśnić, co widzi?

Aby to sprawdzić, naukowcy dostarczyli modelowi zaledwie 15 oznaczonych przykładów dla każdego z trzech głównych przeglądów nieba (ATLAS, MeerLICHT, Pan-STARRS). Każdy przykład zawierał trzy obrazy: nowy alert, zdjęcie referencyjne tego samego fragmentu nieba oraz obraz „różnicowy” podkreślający zmianę, wraz z krótką notatką eksperta. Na podstawie tej minimalnej liczby przykładów i prostych instrukcji w języku naturalnym, system przystąpił do klasyfikacji tysięcy nowych alertów.

Dla każdego przypadku model generował trzy elementy:

-

Klasyfikację: Prawdziwe zdarzenie / Fałszywy sygnał.

-

Ocenę priorytetu: Jak interesujące jest to znalezisko.

-

Wyjaśnienie: Krótki, zrozumiały opis uzasadniający decyzję.

Wyniki okazały się niezwykłe. Model osiągnął około 93% dokładności, co jest porównywalne z wyspecjalizowanymi systemami, ale zrobił to bez potrzeby skomplikowanego treningu.

| Cecha | Tradycyjne modele AI („czarna skrzynka”) | Nowe podejście (przejrzysta AI) |

| Wymagania treningowe | Ogromne, specjalistyczne zbiory danych | Minimalna liczba przykładów (tzw. few-shot learning) |

| Dostępność | Wymaga głębokiej wiedzy z zakresu AI | Wystarczą proste instrukcje w języku naturalnym |

| Wynik klasyfikacji | Prosta etykieta (np. „prawdziwy” / „fałszywy”) | Etykieta, ocena priorytetu i szczegółowe wyjaśnienie |

| Zaufanie i weryfikacja | Wymaga ślepego zaufania lub manualnej weryfikacji | Umożliwia naukowcowi zrozumienie i ocenę logiki AI |

AI, która zna swoje ograniczenia i uczy się od człowieka

Jednym z najważniejszych elementów badania była weryfikacja, czy wyjaśnienia generowane przez AI są faktycznie użyteczne dla naukowców. Zespół ekspertów, składający się z 12 astronomów, ocenił opisy jako wysoce spójne i pomocne w pracy.

Co więcej, w równoległym teście zespół polecił modelowi, by sam ocenił spójność swoich odpowiedzi. Okazało się, że poziom pewności siebie modelu był silnym wskaźnikiem jego dokładności. Wyniki o niskiej ocenie spójności były znacznie bardziej narażone na błędy.

Ta zdolność do samooceny jest kluczowa dla budowy niezawodnego systemu, w którym człowiek i maszyna współpracują. System może automatycznie oznaczać przypadki, co do których ma wątpliwości, i prosić o ich weryfikację ludzkiego eksperta. Dzięki temu uwaga astronomów jest kierowana dokładnie tam, gdzie jest najbardziej potrzebna. Wykorzystując tę pętlę sprzężenia zwrotnego, zespół badawczy poprawił wydajność modelu na jednym ze zbiorów danych z ~93.4% do ~96.7%, co dowodzi, że system potrafi uczyć się i doskonalić we współpracy z człowiekiem.

Demokratyzacja nauki i przyszłość odkryć

Ten przełom otwiera drzwi do zupełnie nowej ery w badaniach naukowych. Ponieważ metoda wymaga jedynie niewielkiego zestawu przykładów i prostych instrukcji, może być błyskawicznie adaptowana do nowych instrumentów, przeglądów nieba i celów badawczych, nie tylko w astronomii, ale i w innych dziedzinach, takich jak medycyna czy biologia.

Wizja na przyszłość to stworzenie autonomicznych „agentów-asystentów” naukowych. Taki system mógłby nie tylko klasyfikować pojedynczy obraz, ale integrować dane z wielu źródeł (np. obrazy i pomiary jasności), weryfikować własną pewność, a nawet samodzielnie zlecać dodatkowe obserwacje robotycznym teleskopom. Ludzki naukowiec interweniowałby tylko w przypadku najbardziej obiecujących i nietypowych odkryć.

Wchodzimy w erę, w której odkrycia naukowe są przyspieszane nie przez algorytmiczne „czarne skrzynki”, ale przez przejrzystych partnerów AI. To ścieżka do systemów, które uczą się razem z nami, tłumaczą swoje rozumowanie i pozwalają badaczom skupić się na tym, co najważniejsze: zadawaniu kolejnych wielkich pytań.

Najczęściej zadawane pytania (FAQ)

-

Czym dokładnie jest „few-shot learning”, o którym mowa w badaniu?

To technika uczenia maszynowego, w której model AI uczy się wykonywać nowe zadanie na podstawie bardzo małej liczby przykładów (w tym przypadku zaledwie 15), w przeciwieństwie do tradycyjnych metod, które wymagają tysięcy lub milionów przykładów. Jest to możliwe dzięki wcześniejszemu treningowi modelu na ogromnych, ogólnych zbiorach danych, co daje mu zdolność do generalizacji wiedzy. -

Dlaczego zdolność AI do wyjaśniania swoich decyzji jest tak ważna w nauce?

Buduje to zaufanie. Naukowiec może zweryfikować, czy logika AI jest poprawna i czy opiera się na właściwych cechach obrazu. Umożliwia to również identyfikację subtelnych błędów w rozumowaniu modelu, a także może prowadzić do nowych odkryć, gdy AI zwróci uwagę na cechy, które ludzki ekspert mógłby przeoczyć. -

Czy ta technologia może całkowicie zastąpić astronomów?

Nie, wręcz przeciwnie. Jest ona projektowana jako narzędzie wspomagające, a nie zastępujące. Automatyzując żmudny i powtarzalny proces filtrowania danych, pozwala astronomom skupić czas i energię na bardziej kreatywnych i złożonych zadaniach, takich jak interpretacja odkryć, formułowanie nowych teorii i planowanie dalszych badań. -

Jakie są potencjalne zastosowania tej technologii poza astronomią?

Potencjał jest ogromny. Podobne podejście można zastosować w każdej dziedzinie, która opiera się na analizie obrazów w poszukiwaniu rzadkich anomalii. Przykłady obejmują diagnostykę medyczną (np. wykrywanie komórek nowotworowych w obrazach patologicznych), monitorowanie bioróżnorodności (np. identyfikacja rzadkich gatunków na zdjęciach z fotopułapek) czy kontrolę jakości w przemyśle. -

Co sprawia, że model Gemini był odpowiedni do tego zadania?

Gemini jest modelem multimodalnym, co oznacza, że został zaprojektowany do jednoczesnego przetwarzania i rozumienia różnych typów danych, w tym tekstu i obrazów. Ta wrodzona zdolność do łączenia informacji wizualnej z instrukcjami w języku naturalnym sprawiła, że idealnie nadawał się do zadania, które wymagało nie tylko klasyfikacji obrazu, ale także jego tekstowej interpretacji.